IA et les LLM : Avancées et Défis dans le Traitement du Langage Naturel

L’année 2024 a été marquée par l’émergence fulgurante de l’intelligence artificielle générative, une avancée technologique qui semble promise à un avenir pérenne et riche en développements. Omniprésente dans les médias, cette thématique a monopolisé l’attention, au point de parfois occulter les autres innovations de l’année. Néanmoins, cette prédominance médiatique ne doit pas être perçue comme un simple effet de mode. L’IA générative et les puissants modèles de langage qui la sous-tendent méritent amplement les projecteurs braqués sur eux. Loin d’être une lubie passagère, cette tendance technologique majeure est appelée à conserver une position prépondérante dans les années à venir, ouvrant la voie à des perspectives captivantes et riches en promesses.

En mai, la capitalisation boursière de NVIDIA, fabricant de « superpuces » prêtes pour l’IA, a dépassé les 1 000 milliards de dollars. Et San Francisco occupe davantage d’espaces de bureau délaissés pendant la pandémie grâce à l’essor des start-ups en intelligence artificielle. On nous a dit que l’IA prendrait nos emplois, créerait d’incroyables nouvelles opportunités professionnelles, identifierait des maladies et découvrirait de nouveaux médicaments, autonomiserait et détecterait les deepfakes, déstabiliserait/transformerait l’éducation et détruirait la démocratie, alimenterait et/ou étoufferait la créativité, serait notre amie et notre thérapeute, et non seulement prendrait nos commandes au drive, mais retournerait aussi les hamburgers. Naturellement, lorsque nous avons réuni des leaders clés et des experts chez Snowflake pour discuter de l’année à venir (et au-delà), l’IA générative a dominé la conversation. « L’IA générative et les LLM sont certainement le sujet le plus chaud en ce moment – ils absorbent tout l’oxygène de la pièce », déclare Mona Attariyan, directrice de l’apprentissage automatique chez Snowflake. « On a presque l’impression qu’il n’y a rien d’autre dans l’apprentissage automatique dont quelqu’un veuille parler. » Et à juste titre, selon Christian Kleinerman, vice-président principal des produits chez Snowflake. « Beaucoup de perturbations réelles arrivent, principalement autour de l’expérience utilisateur finale et de la manière dont les gens interagissent avec la technologie », dit-il. Selon ce que nous constatons, ce n’est pas simplement du battage médiatique. « Le changement radical dont tout le monde parle est réel. L’IA générative et les technologies associées auront un impact sur la productivité, les rôles et responsabilités professionnels. Elles faciliteront les processus créatifs et créeront des expériences entièrement différentes ».

Amanda Kelly, co-fondatrice du framework d’application open source Streamlit, acquis par Snowflake en 2022, souligne que même si les données sont devenues plus accessibles pour les entreprises, elles sont restées enfermées dans des bases de données, avec les data scientists et autres experts techniques jouant le rôle de gardiens. « Mais maintenant, l’IA générative ouvre un accès direct à ces informations pour les décideurs », dit-elle. « Nous commençons seulement à voir comment l’IA nous assistera dans le travail cognitif, de la même manière que les machines robotiques qui peuvent soulever des tonnes aident dans le travail physique. » Pas étonnant, alors, que nos prévisions de données et de technologie pour 2024 soient fortement axées sur l’impact d’une révolution de l’IA centrée sur la puissance des LLM et le potentiel transformateur des interfaces en langage naturel. Soudain, nos ordinateurs peuvent résoudre beaucoup de choses, et nous pouvons essentiellement parler aux données comme si c’était une personne. Comme nous le verrons, cela a des implications pour les emplois dans la tech, la stratégie des données, la cybersécurité et bien plus encore. À court terme, l’impact général de l’IA générative soutenue par les LLM se fera sentir sous la forme d’une productivité accélérée et d’une compréhension améliorée. Ces outils puissants n’accompliront leur travail dans le but d’aider les travailleurs. La génération actuelle d’outils de productivité pour la programmation ou la génération de texte nécessite une surveillance humaine considérable. Mais cela pourrait changer, car ces outils améliorateurs de productivité se développent rapidement. À un moment donné, ils pourraient avoir un plus grand impact sur les besoins en personnel. Pour l’instant, pensez à l’amélioration, pas au remplacement. Prasanna Krishnan, directeur principal de la gestion de produit, Collaboration et Snowflake Marketplace, souligne que le schéma simple de données → insight → action est vraiment difficile. « Cela ressemble à trois étapes, mais le processus peut vraiment être de 10 pour passer des données à l’insight, et de 20 pour passer de l’insight à l’action », dit-elle. « L’IA générative contribuera à réduire les étapes pour l’utilisateur final, pour une efficacité et une vélocité accrues. Peut-être que les 30 étapes entre les données et l’action deviennent cinq. Ou deux. » Sridhar Ramaswamy, vice-président principal de Snowflake, qui a été à l’origine de Google AdWords et a plus récemment créé Neeva, un moteur de recherche basé sur l’IA acquis par Snowflake en 2023, est d’accord sur le fait qu’il y a beaucoup d’efficacité et de commodité à l’horizon. Ramaswamy affirme que pouvoir parler à une application comme si c’était un être humain apportera d’innombrables petites améliorations. « L’autre jour, j’ai dû remplir un formulaire en ligne qui exigeait que je saisisse une heure, mais il ne comprenait ni ’16h’ ni ‘1600’ – j’ai dû comprendre qu’il voulait ‘0400:00′ », dit-il. « Éliminer ce genre de friction pour lisser notre interaction avec la myriade d’entités en ligne avec lesquelles nous traitons chaque jour sera énormément positif. Obtenir des choses comme de meilleures phrases suggérées ou un modèle d’e-mail, ou aider à comprendre un texte complexe, tout cela est positif. » Ce rapport couvrira les effets à court terme de l’IA générative et des grands modèles de langage, et examinera également un peu plus loin dans le futur. Il abordera de nouvelles menaces et stratégies en cybersécurité, l’évolution de l’écosystème open source, et bien plus encore. Mais d’abord, nous explorerons la grande prédiction : l’IA générative change tout, pour le meilleur et pour le pire.

L’IA GÉNÉRATIVE ET LES LLM VONT CHANGER NOS VIES

L’impact de l’IA sur la société sera énorme et rapide.

Tout d’abord, le tableau d’ensemble. Après une année solide d’enthousiasme pour l’IA générative, nous assistons à la réaction inévitable. Alors que les dirigeants d’entreprises ont exprimé de réelles préoccupations concernant les coûts et les défis techniques ralentissant le déploiement de l’IA générative et des LLM, cette technologie n’est pas une bulle sur le point d’éclater. « C’est comparable à l’arrivée du smartphone », déclare Mona Attariyan, directrice de l’apprentissage automatique chez Snowflake. « Depuis l’iPhone, le temps que nous passons à accéder aux données et aux applications a explosé, changeant vraiment notre manière de vivre. L’arrivée de l’IA générative sera un changement similaire, mais beaucoup plus rapide. » « L’idée de la perturbation par l’IA est très réelle », déclare Christian Kleinerman, vice-président principal des produits chez Snowflake. « Il y a beaucoup d’opportunités pour améliorer les choses dans le monde des affaires, que ce soit en rendant les individus plus productifs ou en créant des expériences et interactions innovantes pour les utilisateurs finaux. Cela changera les rôles, les responsabilités et les compétences. » « L’industrie technologique a passé des décennies à apporter des données et des technologies numériques à notre façon de travailler, mais pour la plupart, les fondamentaux de notre travail quotidien n’ont pas beaucoup changé », explique Amanda Kelly, co-fondatrice de Streamlit. « L’industrie atteint maintenant le point où la technologie ne se contente pas d’améliorer l’efficacité, mais donne aux professionnels la possibilité de changer véritablement leur manière de travailler. » À court terme, cela signifie une véritable « démocratisation des données », car les interfaces en langage naturel permettent aux décideurs commerciaux de plonger profondément dans des données qui nécessitaient auparavant l’aide de gardiens nécessaires, tels que des data scientists, des analystes commerciaux et d’autres experts hautement techniques.

Vers un changement des codes distinctifs de l’IA générative.

« De plus en plus, la fonctionnalité de l’IA générative deviendra un prérequis de base », Il y a une ruée massive que beaucoup d’acteurs en place adoptent pour offrir un accès fluide, souple et sans friction aux fonctionnalités qu’ils ont actuellement, et bientôt, tout le monde devrait l’avoir.

Les conséquences négatives de l’IA générative, telles que la manipulation de contenus multimédias par des algorithmes et les inégalités d’accès aux technologies de l’information, seront initialement difficiles à maîtriser et pourraient entraîner des pertes d’emplois importantes.

Il existe une tendance dans l’industrie technologique à minimiser les impacts négatifs potentiels d’une nouvelle technologie. Bien que mettre en avant les aspects positifs soit une vertu, une évaluation réaliste ne peut pas éliminer les aspects négatifs. Les experts de Snowflake ont identifié trois préoccupations immédiates qui seront particulièrement difficiles au cours des premières années de disponibilité généralisée de l’IA générative et des grands modèles de langage. Tout d’abord, il y a l’impact sur les emplois. Les optimistes soulignent que l’IA aidera les humains au lieu de les remplacer, mais lorsque l’IA vous permet de faire le travail de deux personnes, la situation pourrait ne pas être favorable pour l’autre personne. « Beaucoup de personnes impliquées dans ce que nous appelons vaguement le ‘travail de connaissance’, pourraient voir leur emploi disparaître », déclare Sridhar Ramaswamy. (CBS News a rapporté que 4 000 emplois ont été supprimés par l’IA en mai 2023 seulement.) Il note que l’arrivée de technologies passées, y compris le PC, a également éliminé un certain nombre d’emplois et de secteurs économiques entiers qui ont nécessité beaucoup de temps pour rebondir. Un changement rapide induit par l’adoption généralisée de l’IA, dit-il, rendrait difficile l’absorption rapide des travailleurs déplacés ailleurs dans la main-d’œuvre. « Le secteur privé et les gouvernements devront intervenir rapidement. »

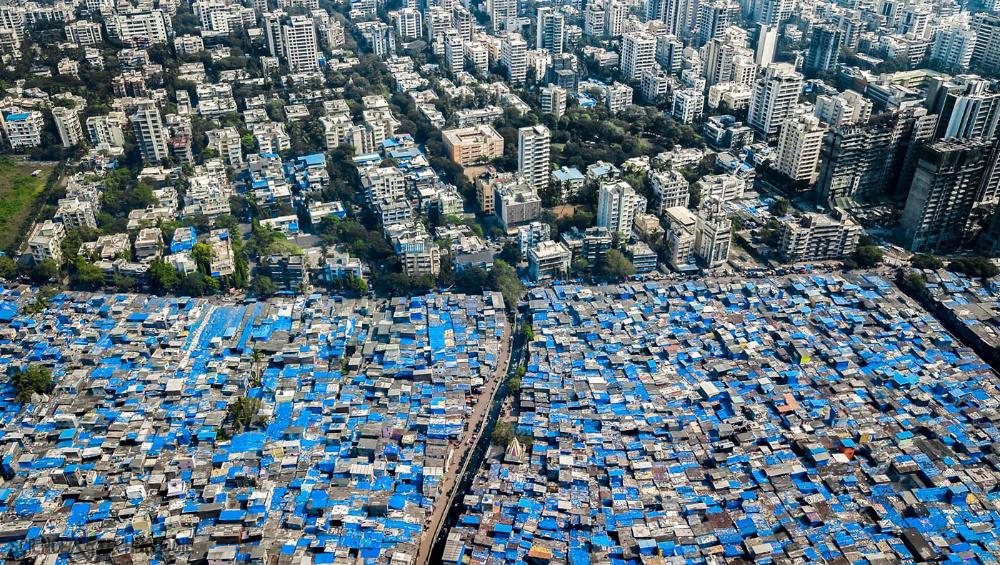

« Ça sera douloureux de s’adapter », déclare Mona Attariyan. « Mais je suis très optimiste que nous réussirons en tant que société. Il y a une prise de conscience importante des inconvénients potentiels, et je vois à la fois les dirigeants d’entreprises et les gouvernements commencer à agir et à aborder ces problèmes dès le début. » La manipulation de contenus multimédias représente un autre point de douleur. Alors que les créateurs responsables d’outils d’IA parlent d’ajouter des filigranes numériques pour faciliter l’identification du contenu falsifié, nous pouvons nous attendre à ce que des acteurs malveillants trouvent des contournements, ou que des fabricants d’outils ne se sentent pas aussi contraints sur le plan éthique. « Dans les prochaines années, nous pouvons nous attendre à une attaque sur ce que nous, en tant qu’humains, considérons collectivement comme notre réalité », déclare Ramaswamy. « Un monde où personne ne peut ou ne devrait faire confiance à une vidéo de vous parce que peut-être elle a été générée par une IA. C’est une réalité très différente de celle dans laquelle nous vivons. C’est un gros problème. » « La désinformation sera douloureuse », convient Attariyan. « Il y a des endroits où des réglementations sont nécessaires, et où les entreprises et les régulateurs doivent agir. » Enfin, à long terme, Ramaswamy s’inquiète d’une détérioration de la fracture numérique. « Une de mes grandes craintes avec l’IA générative est que ces avancées vont aggraver la division entre ceux qui ont et ceux qui n’ont pas, une division qui existe depuis 20 à 30 ans », dit-il. « Je crains que l’IA avancée puisse exacerber les inégalités à l’échelle mondiale. En même temps, j’espère que en rendant l’information beaucoup plus accessible, cette technologie produit une nouvelle génération de jeunes adultes qui comprennent mieux les enjeux et le potentiel, et peuvent contrer ce risque. »

L’IA générative accélère l’innovation incrémentielle, mais ce seront toujours les humains qui effectueront les grands changements.

Deux experts en bases de données chez Oracle ont eu l’idée de se détacher et de construire un type différent de plateforme de données. L’un de ces experts, Benoit Dageville, estime que les algorithmes seront incapables de remplacer ce type de réflexion novatrice. « Ce que nous verrons avec l’IA générative, c’est une innovation plus incrémentielle et itérative », l’IA peut aider dans la recherche, le prototypage, etc., permettant à une entreprise de tester rapidement un nouveau produit. » Une innovation plus profonde nécessite un saut qui va à l’encontre des données. Les humains continueront de stimuler l’innovation et la prise de décision, Les cas d’utilisation impliquent toujours l’humain en plus de la machine. Les humains continueront à assumer la responsabilité, à fournir de l’empathie ; toutes les choses qu’il est difficile de programmer ou à émuler. Mais pour les tâches de calcul intensif ou le travail mécanique, les modèles d’IA seront et sont déjà impressionnants. » Dageville dit qu’il est enthousiaste quant à ce que l’IA générative apporte, mais ne voit absolument pas une menace pour la créativité humaine. Identifier un nouveau segment de clients ? L’IA pourrait probablement exceller dans l’analyse des données. Mais donner naissance à un tout nouveau concept ? L’IA n’est qu’un outil entre les mains du créateur. « Si vous voulez créer une révolution, cette révolution, par définition, n’existe pas », dit-il. « Il n’y a donc pas de données dessus. »

Des balises éthiques pour l’IA émergeront, à la fois du secteur privé et public, plus rapidement que pour d’autres bouleversements technologiques tels que la confidentialité.

Dire qu’il y a des préoccupations concernant le potentiel des dernières avancées en matière d’IA serait dramatiquement minimiser le cas. En mars 2023, plus de 350 experts en technologie, dirigeants d’entreprise et autres, dirigés par Geoffrey Hinton, largement reconnu comme le père de l’IA, ont signé une lettre ouverte d’une phrase déclarant, dans son intégralité : « Atténuer le risque d’extinction lié à l’IA devrait être une priorité mondiale aux côtés d’autres risques à l’échelle de la société tels que les pandémies et la guerre nucléaire ». C’est une mise en garde impressionnante. Pour le développement et l’utilisation responsables de l’IA, il sera essentiel que les acteurs de l’industrie et les gouvernements établissent des règles sûres et éthiques pour l’utilisation de l’IA générative et d’autres avancées. On pourrait craindre le pire en examinant le traitement peu satisfaisant des problèmes de confidentialité dans l’industrie technologique, mais les échecs et les faux départs autour de la confidentialité, tant du secteur public que privé, pourraient conduire à de meilleures directives en matière d’IA, de manière plus opportune. Ce boom de l’IA est arrivé à un bon moment, Nous sommes déjà meurtris par les problèmes de confidentialité, qui sont assez récents pour que nous prenions cette prochaine étape au sérieux. Il y a huit ans, la société aurait peut-être été un peu plus naïve face à ce moment de l’IA. Les acteurs qui créent ces technologies semblent véritablement intéressés à contribuer à résoudre ces problèmes.

Les gouvernements interviennent également plus tôt dans le cycle. Mi-septembre, le Sénat américain a organisé une table ronde d’information privée qui inclut des leaders de OpenAI, NVIDIA, Google, Meta, et plus encore. Mais, une intervention réglementaire rapide pourrait ne pas résoudre le(s) problème(s). « La réglementation étroite de la technologie est très difficile », dit Ramaswamy. Il fait référence à la Section 230, partie du Communications Decency Act de 1996 aux États-Unis, qui accorde l’immunité aux sites Web pour ce que des tiers publient. Bien qu’elle ait rendu possible l’internet tel que nous le connaissons, l’internet tel que nous le connaissons est truffé de mensonges, de discours haineux et de harcèlement. « Nous avons vu que des réglementations bien intentionnées comme la Section 230 peuvent se dérouler de manière moins idéale ». On pense que les leaders de l’industrie, en particulier les responsables de la sécurité de l’information, seront fortement motivés pour prendre en charge de nombreux problèmes éthiques potentiels et les risques de responsabilité de l’IA générative. « Chaque fois qu’une nouvelle technologie comme une IA générative émerge, il y a une bataille car les responsables de la sécurité de l’information sont responsables du risque. Ils vont exiger un cadre pour évaluer ces fournisseurs d’IA générative. Nous devrions trouver des moyens de mesurer la sécurité, la conformité et l’utilisation éthique. » En d’autres termes, le marché sera le facteur contraignant et le gouvernement suivra. « Les signaux du gouvernement sont qu’ils demandent déjà à l’industrie de définir ce que signifie une IA responsable ».

L’IA générative et les modèles linguistiques de grande envergure transformeront l’entreprise et renforceront considérablement la stratégie de données des entreprises leaders de demain.

Pendant des années, les entreprises ont été encouragées ou réprimandées, pour élaborer une stratégie de données complète et tournée vers l’avenir. De plus en plus d’entreprises l’avaient bien compris, les progrès de l’IA menaçant de rendre obsolète le plan de l’année dernière. Heureusement, nos experts étaient unanimes pour dire que si vous avez déjà fait le travail de créer une solide stratégie de données, vous êtes sur la bonne voie.

« L’ère de l’IA générative ne nécessite pas un changement fondamental dans la stratégie de données, elle appelle à une accélération de la tendance à briser les silos et à ouvrir l’accès aux sources de données où qu’elles soient dans l’organisation. »

Le changement concerne le niveau d’importance de votre stratégie de données et la rapidité avec laquelle vous devez la mettre en œuvre et investir. « Si vous n’accélérez pas, vous risquez d’être laissé pour compte, pratiquement du jour au lendemain. » Cela ne signifie pas poursuivre toutes les promesses apparemment illimitées de l’IA générative d’un coup. L’aide à la programmation de base et à la rédaction de textes est agréable, mais ce n’est pas ce qui différencie une entreprise. Les leaders devraient toujours donner la priorité aux insights uniques qui peuvent être tirés de leurs propres données. « Il y aura des applications de l’IA générative dans presque tous les aspects de votre entreprise » Il faut continuer à nous concentrer sur nos besoins fondamentaux, sur les choses qui nous préoccupent, puis investir dans celles-ci !

Cela signifie que la manière dont vous gérez et gouvernez vos données devient d’une certaine manière encore plus importante. Il n’y a pas de place pour les raccourcis ou les approches à moitié cœur. « La gouvernance est le strict minimum ». La sécurité, la gouvernance et la conformité sont le prix d’entrée minimum dans le monde de l’IA générative et des LLM (Large Language Models). S’il y a un sujet sur lequel la nouvelle ère de l’IA met au défi le statu quo de l’informatique, Bedi et Anoosh Saboori disent que c’est l’endroit où une entreprise place ses données. « L’IA générative augmentera la tendance vers une centralisation des données sur une plateforme de service gérée qui offre la sécurité et la gouvernance nécessaires, et crée une seule source de vérité pour les LLM (Large Language Models) et tout le reste », déclare Bedi. Et il dit qu’il peut recommander une excellente plateforme pour cela, si quelqu’un cherche… Saboori, responsable de la sécurité des produits chez Snowflake, déclare que les nombreux retardataires de l’adoption du cloud devront rapidement s’adapter. « Gen AI rendra difficile le maintien de vos données sur site », dit-il. « C’est encore une discussion importante aujourd’hui, car la majorité des charges de travail ne sont toujours pas dans le cloud. » Cette migration vers le cloud, note-t-il, compliquera la stratégie de sécurité et de conformité : « Les clients adoptant une stratégie multi-cloud finissent souvent par distribuer des données et des modèles sur de nombreuses plates-formes avec des capacités de sécurité et de gouvernance différentes. Il devient très difficile de gérer votre posture de sécurité et de gouvernance dans de tels environnements distribués. »

L’IA SERA VOTRE COLLÈGUE DE TRAVAIL

L’une des idées les plus passionnantes pour la productivité au travail sera le déploiement d’assistants d’IA qui aident les nouveaux employés à devenir et à rester efficaces et performants. L’intégration de nouveaux travailleurs est un processus complexe d’éducation du travailleur sur les systèmes, les processus et la culture, tout en fournissant un accès rapide aux systèmes et projets appropriés (uniquement). Il prévoit des assistants d’IA adaptés à votre département et à votre rôle spécifique qui fourniront cette orientation et vous accompagneront tout au long de votre mandat au sein de l’entreprise. « Il sera lié à votre personne », dit-il. « Nous pouvons fournir une productivité énorme grâce à cela. À mesure que vos processus et besoins deviennent plus matures, vous formez l’agent à faire la même chose en votre nom la prochaine fois. Et lorsque nous embauchons une nouvelle personne dans votre organisation, cette personne bénéficie de cette richesse de connaissances dès le début. » L’idée est déjà en train de se concrétiser. Fin août, Axios a rapporté que Walmart lancera une application d’IA générative utilisant un LLM tiers non nommé formé sur des informations d’entreprise. « My Assistant » aidera ses 50 000 employés non liés au magasin à résumer de longs documents, créer du contenu, etc. Attendez-vous à ce que de nombreuses entreprises suivent le mouvement.

Les LLMs/Gen AI vont décupler les opportunités de monétisation des données.

Parce que les entreprises ont beaucoup de données sensibles à gérer, on peut s’attendre à ce que la plupart de leurs LLMs soient internes, plutôt que de recourir à des outils publics comme ChatGPT. Imaginez une entreprise de transport achetant un modèle fondamental auprès de fournisseurs tels qu’OpenAI, puis le formant avec ses propres données propriétaires. Mais elles voudront plus que cela. « Non seulement les entreprises vont fournir leurs propres données à leurs LLM internes, mais elles voudront acheter des ensembles de données externes spécifiques à leur industrie/marché », explique Jennifer Belissent, stratège principale des données chez Snowflake. Elle dit que les dirigeants d’entreprise auront besoin d’une vision plus large que ce que leurs propres données fournissent. « Un responsable de la protection des données m’a dit qu’avec leurs propres données, ils ne peuvent voir qu’en interne », dit-elle. « Ils ont besoin de tendances régionales, de benchmarks sectoriels, etc. Ils doivent comprendre le contexte dans lequel ils exercent leurs activités pour découvrir les opportunités qui existent. » Ce besoin signifie que les entreprises peuvent être plus que de simples consommatrices de données, ajoute Belissent. Elle cite ADP, un fabricant de logiciels de paie, dont le produit de données ADP Insights examine la croissance des salaires aux États-Unis par région, industrie, genre, et plus encore. « La demande croissante de données offre l’opportunité de vendre vos données à un marché très demandeur », dit-elle.

Les LLMs doivent rendre la consommation basée sur l’utilisation encore plus attractive !

Vous vous souvenez du temps où l’installation de logiciels commençait par l’ouverture d’une boîte contenant deux, six, voire une douzaine de disques CD-ROM ? Personne ne regrette ces jours-là. Le modèle tarifaire des logiciels a évolué de « acheter un package logiciel une fois ; racheter dans cinq ans pour une version améliorée » à « abonnement logiciel en tant que service signifie payer par utilisateur (qu’ils l’utilisent ou non) pour l’accès à un logiciel constamment mis à jour. » Déjà, le modèle SaaS évolue vers une tarification basée sur la consommation : « payez pour les données auxquelles vous accédez ou les ressources informatiques que vous consommez », comme nous le voyons avec les fournisseurs de services cloud. Prasana Krishnan, directrice principale de la gestion des produits, Collaboration et Snowflake Marketplace, affirme que la nouvelle ère de l’IA augmentera considérablement l’adoption des modèles de tarification basés sur la consommation. Il est facile de facturer un abonnement logiciel, dit-elle, même si ce modèle basé sur l’utilisateur peut être inefficace. « Mais lorsque nous parlons de services ou d’applications qui tirent parti d’un modèle formé avec une variété de sources de données, les propriétaires de données devraient être rémunérés à mesure que leurs données sont utilisées. » Ainsi, l’attrait de payer pour les données et les applications en fonction de l’utilisation réelle. Adopter ces modèles de consommation sera un défi pour les organisations qui ne sont pas habituées au paiement à l’utilisation. « Avec de vrais modèles basés sur l’utilisation, vous avez besoin de visibilité sur les coûts et d’établir des budgets », dit-elle. Fondamentalement, lorsque l’informatique confie des services basés sur l’utilisation à ses utilisateurs, c’est comme si les parents donnaient une carte Mastercard à leur adolescent. Vous voulez certainement fixer une limite de crédit.

« Nous aidons les clients à le faire sur Snowflake – ils sont avertis lorsqu’ils approchent d’un seuil budgétaire. Tout est une question de compréhension de vos dépenses, de mise en place de contrôles pour fixer des limites et de prise facile d’actions pour optimiser. » En plus de l’efficacité, elle affirme que les modèles de tarification basés sur la consommation stimuleront considérablement l’innovation. « Nous verrons plus de prototypage rapide avec l’IA, car dans cette phase d’expérimentation, la tarification basée sur l’utilisation est vraiment puissante », dit-elle. « Sinon, vous êtes coincé à négocier un contrat de 100 000 dollars simplement pour prototyper une idée non prouvée. » Cela ne signifie pas que le modèle d’abonnement est condamné. Dans certains cas, la tarification basée sur l’utilisation peut être un niveau d’entrée ; mettez un prototype en production où les données ou les ressources informatiques sont utilisées de manière cohérente et vous pourriez décider de passer à un tarif fixe. « Une fois que l’idée d’un développeur passe de l’expérimentation à la production et qu’il y a une utilisation constante et élevée », déclare Krishnan, « elle pourrait passer à un abonnement avec un prix fixe tout compris. »

CE N’EST PAS SEULEMENT L’IA GÉNÉRATIVE – CE SONT LES APPLICATIONS QUI RÉVOLUTIONNERONT NOTRE FAÇON DE VIVRE ET DE TRAVAILLER.

L’excitation autour de l’IA générative est souvent exprimée comme « pouvoir parler/interagir directement avec les données », ce qui n’est pas tout à fait exact. Ceux qui interagissent directement avec les données se trouvent dans une salle arrière à écrire des requêtes Python. Le reste d’entre nous va interagir avec des applications – comme ChatGPT – qui font l’intermédiaire entre nous et le grand modèle de langage. Et bien sûr, les données elles-mêmes ne sont pas stockées sur l’appareil que nous utilisons pour accéder à l’application. Cela signifie que l’ère de l’IA avancée concerne plus que les données et les algorithmes. « La révolution n’est pas l’IA, ou l’IA générative », déclare Benoit Dageville. « C’est l’IA plus le cloud plus les applications. Ce qui a rendu le smartphone révolutionnaire n’était pas la fonctionnalité vocale ou textuelle – c’étaient les applications. » Les smartphones ont engendré des boutiques d’applications, remplies d’applications simples qui exécutent des fonctions distinctes. C’est ainsi que nous allons interagir avec l’IA. « Une explosion d’applications s’est déjà produite », note Christian Kleinerman. « Mais elle sera considérablement accélérée par l’IA générative et les LLM. Il y aura une grande catégorie d’applications autour de ces technologies, et de nombreuses applications auront une recherche basée sur l’IA et un traitement du langage naturel intégrés. » « Tout est en train de devenir une application », confirme Amanda Kelly. « Et j’ai de plus en plus vu des applications très spécifiques conçues pour gérer une tâche ETL spécifique, un pipeline ou un type de données. Les LLM faciliteront cela, en rendant plus simple la création et l’utilisation d’applications très utiles et spécifiques à un cas d’utilisation. » Ainsi, Dageville affirme que les entreprises devront examiner non seulement l’adoption de l’IA, mais aussi la manière dont leurs utilisateurs interagiront avec elle. « Alors que les entreprises essaient de comprendre quoi faire avec l’IA, elles doivent réfléchir à l’application dont elles ont besoin comme interface entre ces données et leurs utilisateurs, qu’il s’agisse d’employés ou de clients. »

L’IA NE DÉTRUIRA PAS INTERNET NI LES MODÈLES DE REVENUS BASÉS SUR LA PUBLICITÉ, BIEN AU CONTRAIRE !

L’une des craintes initiales exprimées à la suite de ChatGPT était que si les gens commencent à demander à l’IA de résumer le contenu Internet au lieu de le rechercher eux-mêmes, le trafic qui alimente Internet basé sur la publicité se tarira, et donc, Internet tel que nous le connaissons aussi. Pas si vite, dit Sridhar Ramaswamy, SVP de Snowflake, qui a joué un rôle clé dans la création et la direction du programme AdWords de Google, et qui a tenté de défier Internet basé sur la publicité en créant Neeva en tant que moteur de recherche alimenté par l’IA, respectueux de la vie privée et sans publicité. Il dit que l’Internet tient bon. « L’Internet est une entité assez robuste et adaptable », dit-il. « Le modèle publicitaire est incroyablement puissant, et il y a énormément d’argent en jeu. Ce modèle continuera à prospérer à l’ère de l’IA. » Non seulement cela, mais attendez-vous à ce que les publicités deviennent plus personnelles. « Votre célébrité préférée vous parlera directement dans une publicité », dit-il. « Qui sait, peut-être qu’un Michael Jordan virtuel appellera pour dire : ‘Eh bien, Sridhar, achète les nouvelles Air Jordans.' »

La création de modèles IA sera normalisée, externalisée et spécialisée. Il faudra du temps pour une adoption généralisée des LLM (grands modèles de langage) dans le monde des entreprises. La « taille » dans « grands modèles de langage » les rend coûteux à former et à exécuter. La recherche est déjà bien avancée sur la façon de créer des LLM moins importants qui fonctionnent avec moins de paramètres, formés pour des fonctions spécifiques. ChatGPT peut résumer de longs textes, suggérer des recettes en fonction de ce qui se trouve dans votre réfrigérateur ou planifier vos vacances de rêve à Buenos Aires. C’est beaucoup plus de polyvalence que ce dont vous aurez besoin pour une application qui aide votre directeur financier à gérer les coûts ou qui aide votre équipe de vente à cibler de nouveaux segments de clients. « Il y aura quelques géants qui construiront le modèle général ‘tout pour tous les utilisateurs' », dit James Malone, directeur de la gestion des produits chez Snowflake pour les data lakes et le stockage de données. « Mais beaucoup plus de fournisseurs se concentreront de manière hyper-focalisée et hyper-ajustée sur des industries, des cas d’utilisation et des types de données spécifiques. » « Il y aura un marché robuste et concurrentiel de modèles fondamentaux, dans le cadre d’une économie plus large de fabricants de modèles personnalisés pour diverses industries – santé, vente au détail, finance et fabrication, par exemple », explique Christian Kleinerman, SVP du produit. « Ensuite, les entreprises emballeront ces modèles ensemble et ajouteront leurs propres données. » « Les éditeurs de logiciels ont tendance à acquérir de plus petites entreprises pour intégrer leurs spécialités en interne », explique Malone. « Mais ce ne sera pas la tendance avec l’IA. Les petites entreprises existeront pour ajuster et réutiliser des modèles en fonction de besoins spécifiques. Il y aura une chaîne d’approvisionnement en IA qui comprendra de grands modèles généraux et les modèles plus petits, spécialisés par industrie. » Alors, des centaines d’entreprises chercheront toutes à ajuster et à réutiliser deux ou trois grands et coûteux LLM ? « Le marché de ces modèles fondamentaux sera robuste, sans consolidation significative, pendant au moins cinq ans », déclare Kleinerman, ajoutant que l’IA évolue si rapidement et qu’il y a tellement d’incertitudes sur l’adoption qu’il est difficile de prédire plus loin. « Mais à un moment donné, ce marché se consolidera probablement. »

L’OPEN SOURCE CONTRIBUERA DE MANIÈRE SIGNIFICATIVE À L’IA AVANCÉE. ET VICE VERSA.

Les fondateurs de Streamlit, Amanda Kelly et Adrien Treuille, sont optimistes quant à l’avenir des logiciels open source, tant en termes de son impact sur les projets d’IA générative et de LLM que sur la manière dont ces technologies d’IA influenceront le mouvement open source dans son ensemble.

- L’écosystème open source autour de l’IA générative suivra et rivalisera avec l’écosystème corporatif. « L’un des développements les plus frappants des six derniers mois est l’incroyable innovation dans l’open source, en partie grâce à Meta qui a rendu open source LLaMA et LLaMA 2, mettant essentiellement ces outils entre les mains des universitaires et de la communauté open source », explique Treuille. « Les gens ont rapidement découvert comment réutiliser les LLMs pour toutes sortes de choses incroyables. » Nous continuerons à observer des développements majeurs et importants dans les LLMs et les grands modèles génératifs par la communauté open source, dit-il. « Nous verrons une combinaison de certains modèles devenant open source, ainsi que de nouvelles technologies comme Low Rank Adaptation [LoRA], qui permet aux universitaires d’ajuster rapidement des modèles existants plus rapidement et en consommant moins de mémoire », explique-t-il. « Cela a totalement surpris tout le monde, de voir ce véritable niveau d’innovation en dehors des structures corporatives, dans ce monde prétendument impossible des modèles de 70 milliards de paramètres. » Kelly dit que la nature collaborative des projets open source conduit à de meilleurs résultats. « Plus les choses sont exposées à la lumière du jour, plus vous avez de conversations, meilleures sont les décisions auxquelles vous parvenez », dit-elle. « Avec l’open source, vous bénéficiez de nombreuses perspectives différentes, de nombreuses personnes passionnées qui contribuent. »

- L’IA générative aidera le mouvement open source plus large, au-delà de l’IA, à accélérer et à démocratiser. Au-delà des projets orientés vers l’IA, la communauté open source bénéficiera de l’IA générative pour la même raison que de nombreux autres efforts : l’élimination efficace des tâches humaines fastidieuses. « Un coût très significatif du développement open source n’est pas d’écrire le code », explique Treuille. « C’est toute la documentation, la gestion des bugs, les discussions avec les gens, la réponse à des millions de demandes, la vérification des exemples de code sur GitHub, et plus encore, tout cela étant très intensif en ressources humaines. En aidant dans tous ces aspects, les LLMs accéléreront le développement open source et rendront les équipes plus petites plus rapides et plus puissantes. »

RÔLES ET TECHNIQUES DANS UN MONDE DE L’IA

Les data scientists, ingénieurs en données et analystes BI vont vivre une expérience passionnante. Les LLM et l’IA générative auront un impact considérable sur les utilisateurs de données les plus techniques, et c’est en grande partie pour le mieux. La plainte traditionnelle en science des données est que beaucoup du travail réel consiste en une préparation de données de base, des tâches ennuyeuses qui ressemblent à devoir tondre tout le champ et peindre les lignes blanches avant de pouvoir jouer un peu au football. La promesse de cette nouvelle ère de l’IA est que bon nombre de ces tâches ingrates seront automatisées par des outils d’IA plus intelligents.

- L’ingénierie des données évoluera – et sera très valorisée – dans un monde dominé par l’IA. On pourrait pardonner aux ingénieurs en données de craindre que l’IA ne dévore leurs emplois. Ils n’ont pas à s’inquiéter, selon Mona Attariyan, directrice de l’apprentissage automatique. « Les bons ingénieurs en données seront très appréciés », dit-elle. « Le travail principal d’un ingénieur en données est de s’assurer que les données arrivent et sont organisées correctement. Vous ne pouvez pas exploiter vos données ou la puissance des LLM sans le travail essentiel d’un ingénieur en données. » Les pipelines de données construits et gérés par les ingénieurs en données seront peut-être le premier endroit où se connecter avec les LLM pour débloquer de la valeur. Les ingénieurs en données seront ceux qui sauront comment consommer un modèle et le brancher dans un pipeline de données pour automatiser l’extraction de valeur. « Leur expertise sera toujours nécessaire, y compris de nouvelles manières », explique James Malone, directeur de la gestion des produits. « Les ingénieurs en données devront résoudre des défis uniques de cas d’utilisation. Ils seront également les experts qui pourront superviser et comprendre le travail qui était autrefois effectué par les ingénieurs en données mais qui sera routinière ment réalisé par l’IA générative. »

- Les ingénieurs de données auront plus de plaisir. Certains des problèmes auxquels ils sont confrontés vont disparaître. Par exemple, construire encore un autre modèle d’analyse de sentiment peut être sans pertinence. Beaucoup de problèmes vont changer et de nouveaux sont déjà apparus. Par exemple, comment fournir les bonnes informations à un LLM dans le cadre d’un contexte, comment minimiser l’hallucination, ou comment inciter correctement un LLM sont des défis entièrement nouveaux auxquels les data scientists et ingénieurs sont confrontés aujourd’hui. L’IA générative rendra les emplois de data science plus attractifs. Sur certains commentaires d’étudiants, lorsque vous leur demandez s’ils aimeraient devenir ingénieurs de données, ils critiquent surtout le travail de préparation, et disent “comment vous passez tout votre temps à faire des tâches qui ne sont pas intéressantes”. Une grande partie desquelles seront gérées par l’IA. C’est l’histoire de la technologie : elle aide à automatiser les choses qui ne sont pas le travail intéressant. » Ces ingénieurs de données amateurs de plaisir devront ajuster un peu leurs compétences. Tout comme l’infrastructure cloud a obligé les organisations informatiques à apprendre de nouvelles compétences en passant de constructeurs d’infrastructure et de logiciels à des gestionnaires d’infrastructures et de fournisseurs de logiciels tiers, les leaders de la data science devront apprendre à sélectionner et intégrer les bons fournisseurs externes de modèles d’IA. « Vous pouvez penser à un data scientist ou à un analyste commercial comme un intermédiaire entre les données brutes et le consommateur », explique Adrien Treuille, qui a cofondé Streamlit avec Kelly. « Le travail doit être précis, et si leur rapport ou tableau de bord est livré avec des centaines de réserves, l’ingénieur de données doit faire plus de travail. Lorsque cela devient le travail du LLM, dit Treuille, l’ingénieur de données passera de la création du tableau de bord à aider le LLM à répondre correctement aux questions. « l’ingénieur de données devra dire au modèle : ‘Voici un tas de contexte sur nos données et comment elles fonctionnent, et donc lorsque vous interagissez avec le PDG, connaissez toutes ces choses' », dit-il. « La science des données devient l’art de formaliser et d’incarner les métadonnées de l’entreprise de manière à ce que le LLM puisse répondre de manière précise au nom d’une large gamme d’utilisateurs. »

- Les analystes devront monter en compétence. Les analystes d’aujourd’hui créent généralement et présentent un rapport préétabli, suivant de nouvelles requêtes lorsque des dirigeants ont une question spécifique supplémentaire. À l’avenir, les dirigeants s’attendent à interagir directement avec les données résumées dans ce rapport général. Ce libre-service permettra aux analystes de travailler sur des questions plus approfondies, apportant leur propre expertise à ce que l’organisation devrait vraiment analyser. Ce renforcement, selon Sunny Bedi, CIO de Snowflake, est inévitable, et cela impose aux analystes d’améliorer leurs compétences. « Si je vous propose soit huit tableaux de bord soit une application qui vous permet d’interroger les données en langage naturel, que préféreriez-vous ? » demande Bedi. « La personne en charge de la BI qui rédige ces tableaux de bord voudra monter en compétence pour résoudre les problèmes que l’interface IA ne peut pas résoudre. »

- Les développeurs s’attendent à être 30% plus efficaces en utilisant des assistants d’IA générative. Le directeur de l’informatique, Sunny Bedi, a demandé à son équipe de développement d’estimer quelle proportion du code qu’ils écrivent pourrait être gérée par un outil d’IA générative, et ils ont systématiquement estimé à 30%. Bien que cela reste à prouver, ce niveau d’efficacité serait vraiment révolutionnaire, affirme-t-il. « Au-delà de cette efficacité initiale », ajoute-t-il, « il y a la réutilisabilité et le partage. Un morceau de code généré par l’IA qui rend le développeur 30% plus efficace aujourd’hui peut être réutilisé sur d’autres projets, augmentant l’efficacité globale. » De plus, il observe que les tests et l’assurance qualité pourraient éventuellement être assistés par un agent d’IA, entraînant des déploiements plus rapides et de meilleure qualité. Mais les codeurs devront toujours coder. Pour l’instant. « Vous ne pouvez pas déboguer du code ou éditer un texte à moins d’avoir des compétences en tant que codeur/écrivain vous-même », déclare Attariyan. « À court terme, ces outils visent à faire plus rapidement des choses que vous pourriez certainement faire vous-même. » Comme d’autres, elle hésite lorsque l’on demande de regarder au-delà de cinq ans. « C’est difficile à prédire », admet-elle. « Les choses évoluent si rapidement, les systèmes s’améliorent tellement, il n’est pas clair à quel point diverses sorties d’IA auront besoin de supervision à long terme. »

QUOI CRAINDRE UNE FOIS QUE VOUS AVEZ FINI DE VOUS INQUIÉTER DE L’ADOPTION DE L’IA

Les grandes questions sur l’IA générative aujourd’hui concernent la manière d’adopter cette technologie puissante. Nous avons demandé à nos experts à quoi d’autre les dirigeants et les consommateurs devraient se préoccuper.

- Les PDG doivent réfléchir à la régulation. « Aujourd’hui, les chefs d’entreprise se demandent : ‘Comment puis-je tirer parti de l’IA générative ? Est-ce que je vais assez vite ?’ Mais ils doivent équilibrer la rapidité avec la minutie. À mesure que des réglementations telles que l’AI Act de l’UE se multiplient, les dirigeants voudront s’assurer qu’ils sont en conformité. Ils se demanderont : Comment puis-je m’assurer que mes utilisations actuelles et futures de l’IA sont à l’abri des risques de sanctions réglementaires et de dommages à ma réputation ?

- Et la gouvernance des données. « Plus de données sont générées, plus de parties s’intéressent aux données, et il y a plus d’outils pour travailler avec les données. Et le défi de gouverner les données ne fera que s’accentuer. Si vous ajustez un LLM avec vos données propriétaires, des données sensibles peuvent émerger. L’IA aggrave le problème familier car vous avez moins de contrôle et de visibilité sur ce que la machine fait. La traçabilité des données, la gouvernance de la provenance deviennent encore plus importantes. »

- Les consommateurs vont exiger la transparence. « Il est possible que le consommateur moyen ne réfléchisse pas beaucoup à la manière dont l’IA l’affecte. Beaucoup de gens sont souvent à l’aise ou négligents quant à la manière dont les entreprises utilisent leurs données. Mais à mesure que l’IA alimentée par les LLM prendra des décisions qui nous affectent, comme la possibilité d’obtenir un prêt, un entretien d’embauche, une intervention médicale, les gens exigeront plus de transparence sur la manière dont les modèles de données les affectent. »

CYBERSÉCURITÉ : LE DÉFI DE L’IA

Nous avons déjà fait allusion à certains des risques inhérents au déploiement de nouvelles technologies d’IA. Ce n’est pas que l’avènement de l’IA générative et des LLM soit particulièrement périlleux—toutes les nouvelles technologies exigent que l’on considère leurs risques. Cependant, les développements en IA évoluent rapidement et sont impressionnants par leur ampleur et leur capacité, ce qui rendra le travail des équipes de sécurité particulièrement difficile. Les CISO doivent guider l’adoption responsable de ces outils très précieux. Certaines entreprises [dont Apple, Amazon et JPMorgan] auraient restreint l’utilisation de chatbots et d’assistants de codage IA gratuits pour générer du texte ou du code, car inévitablement des données propriétaires se retrouveraient dans ces modèles. C’est une préoccupation immédiate. Mais à plus long terme, l’IA générative est trop puissante, trop attrayante. Si les responsables de la sécurité ne fournissent pas d’alternatives responsables, le personnel frustré créera des solutions de contournement et des technologies informatiques fantômes. Les CISO doivent aider à trouver un équilibre où l’innovation est accessible, pour le bien de l’entreprise, de manière à limiter le risque de compromission de données sensibles, d’amendes réglementaires ou de dommages à la réputation.

Les LLM seront sécurisés en interne. Plus tôt, Christian Kleinerman et James Malone ont discuté de la chaîne d’approvisionnement en IA qui permettra aux entreprises de construire des modèles de langage larges et moins larges dans leurs environnements sécurisés. C’est essentiel pour une bonne sécurité, selon Mario Duarte, VP de la sécurité chez Snowflake. « Bien sûr, les entreprises maintiendront des outils d’IA générative et des LLM à l’intérieur de leurs périmètres de sécurité, mais cela crée ses propres défis en matière de sécurité », dit-il. « Premièrement, pouvez-vous faire confiance aux sources de données externes et aux modèles open source ? Deuxièmement, une grande partie du risque lié à toute technologie concerne la mauvaise configuration », dit-il. « Tout comme une erreur de l’utilisateur peut rendre vos données vulnérables sur un fournisseur de services cloud, une erreur humaine peut rendre les outils basés sur les LLM vulnérables. Et personne n’a encore d’expérience dans la maintenance et la sécurisation de ces modèles ». Une autre préoccupation fréquemment discutée concerne la contamination d’un modèle par des données incorrectes, en particulier si elle est délibérément introduite par un adversaire. « Bien que les ‘sorties inexactes de nos outils de données’ semblent être moins une préoccupation directe en matière de cybersécurité », dit Duarte, « c’est en fait une forme d’ingénierie sociale, et donc cela relève bien du domaine de la sécurité ». La chaîne d’approvisionnement en données IA sera une cible d’attaque. Éventuellement. En creusant la vulnérabilité potentielle des données elles-mêmes, il est important d’évaluer réaliste le risque. Nous parlons d’un adversaire jouant un jeu relativement long en injectant de fausses données ou biaisées dans des LLM fondamentaux. Imaginez une opération de propagande où un acteur politique diffuse du contenu qui obscurcit la vérité sur un conflit entre États-nations, l’intégrité électorale ou un candidat politique. « Vous voyez déjà cela se produire avec des bots utilisés sur les médias sociaux pour influencer le zeitgeist (l’air du temps) », Il n’est donc pas farfelu d’imaginer une opération spécifiquement conçue pour influencer un modèle fondamental formé sur l’internet ouvert. Et du jeu politique aux attaques commerciales, il n’y a pas un énorme écart. « Je connais un cas où l’entreprise A a été endommagée quand un rival a alimenté un journaliste d’une fausse rumeur selon laquelle A allait être acquise », dit Duarte. « Cette rumeur a créé une hésitation parmi les clients potentiels qui ont nui à l’entreprise A et donc ont aidé le rival. » Plante

L’IA générative améliorera la détection des intrus

Les bonnes nouvelles du côté de l’IA et de la cybersécurité. Les plus grands problèmes en matière de sécurité informatique sont le temps qui s’écoule entre le moment où un acteur malveillant accède à vos systèmes et le moment où vous vous en rendez compte (éventuellement parce qu’ils réussissent leur attaque) et que vous fermez la porte de la grange. Divers rapports sectoriels estiment le temps médian de présence à environ deux semaines, ce qui est long lorsque les données se déplacent à la vitesse de la lumière. Anoosh Saboori, responsable de la sécurité des produits, affirme que l’IA améliorera considérablement la détection automatisée des activités des intrus. « L’IA peut être utilisée pour améliorer énormément différents aspects de la sécurité, depuis l’expérience naturelle d’interaction avec les produits de sécurité, facilitant la compréhension par des non-experts en sécurité afin de poser des questions significatives sur la sécurité du système, jusqu’à la réduction du temps nécessaire pour détecter les anomalies et les intrusions, allant jusqu’à la réponse automatisée et l’analyse médico-légale. Par exemple, nous disposons déjà de nombreuses données comportementales qui peuvent nous aider à comprendre un comportement malveillant ou incohérent », explique-t-il. « Les variations par rapport à la ligne de base concernant l’endroit et le moment où l’employé X se connecte, et les systèmes auxquels il accède, peuvent être signalées comme l’utilisation de données d’identification volées ou une activité malveillante interne. L’IA générative sera bien meilleure pour évaluer et signaler cette activité. »

L’IA sera une énorme aubaine pour les cybercriminels avant de devenir une aide pour les équipes de sécurité.

Maintenant, les mauvaises nouvelles. Les cybercriminels bénéficieront du déploiement généralisé d’outils avancés d’IA avant que leurs cibles ne puissent mettre en place l’IA pour leur propre défense. « Les entreprises légitimes sont prudentes lorsqu’il s’agit d’adopter et d’utiliser de nouvelles technologies, en raison des coûts, des exigences réglementaires et des risques de réputation si cela est mal fait », explique Mario Duarte. « Les criminels ne vont pas attendre. Ainsi, au début, ils auront toute la puissance de feu des LLM et de l’IA générative, et les défenseurs seront à la traîne. » À terme, le terrain de jeu pourra s’équilibrer. Il y aura beaucoup de difficultés d’ici là.

L’IA générative rendra les cyberattaques bas de gamme plus intelligentes.

L’idée que des cybercriminels déploient l’une des technologies les plus avancées de la planète pourrait évoquer des images de malveillance digne de la science-fiction, avec des attaquants élites et sophistiqués lançant des attaques brillantes pour lesquelles nous n’avons même pas encore de noms. Bien sûr, c’est probable, mais dans un premier temps, il s’agira de nombreuses attaques de base qui fonctionnent déjà si bien. « Le phishing reste un gros problème », notant que la plupart des e-mails de phishing sont plutôt maladroits et stupides. « L’IA générative rendra ce vecteur d’attaque déjà efficace encore plus réussi. Je ne pense pas que les gens soient prêts pour ça. »

Les cyberattaquants continueront de se déplacer vers la gauche.

Notre dernière réflexion concerne moins un problème d’IA que la question du DevOps/DevSecOps. Ces pratiques déplacent les tests et la remédiation vers la gauche du diagramme du cycle de vie du développement logiciel (vers les développeurs) et automatisent une grande partie du travail de production du côté droit. Un avantage appréciable de l’automatisation est qu’elle élimine les opportunités d’erreur humaine, qui donne souvent aux cybercriminels leur point d’entrée. « L’aspect ‘déplacement vers la gauche’ du DevOps/DevSecOps est rendu possible par l’automatisation. Et automatiser la fonctionnalité dans l’environnement de production signifie moins d’erreurs humaines que les attaquants peuvent exploiter », déclare Duarte. « Les attaquants cherchent donc maintenant des moyens d’entrer via les environnements de développement, car c’est là que les erreurs humaines peuvent encore être découvertes et exploitées. » Il est plus difficile pour les équipes de sécurité de se défendre contre de telles attaques, ajoute Duarte, car il est beaucoup plus difficile de créer des bases pour l’activité de développement acceptable que pour un environnement de production automatisé et bien géré. « Le développement est par nature chaotique et expérimental, donc comprendre ce qui est normal et anormal dans un environnement de développement est très difficile », dit-il. « Mais nous devons le comprendre. C’est là que vous mobilisez tout – humains, apprentissage automatique, IA – pour comprendre à quoi ressemble un comportement suspect. » Et malgré les difficultés, il affirme être confiant que, à long terme, les équipes de sécurité pourront suivre le rythme des attaques de déplacement vers la gauche.

Foisonnement d’innovations !

Les défis les plus susceptibles d’influencer les entreprises au cours des prochaines années, allant d’un à cinq ans, se concentrent sur l’adoption de grands modèles linguistiques et d’IA générative, ainsi que sur la priorité constante de la sécurité et de la gestion des risques. Cependant, cela ne signifie pas que ce sont les seules préoccupations dans le domaine des données et de la technologie. On observe de nombreuses autres technologies qui auront un impact significatif ou transformeront le paysage, bien que l’attention puisse être moindre pendant l’engouement actuel pour l’IA. C’est le côté positif du monde technologique, où de nombreuses avancées sont en cours et auront des conséquences considérables.

Derniers Articles

Sur le même sujet

Axel Louineaux

Annonces PARTENAIRES

Centre de formation CFA - Certifié Qualiopi Diplômes RNCP et certifications RS.

3axes academy : Formation, Innovation, Excellence

VOIR NOS FORMATIONSOffrez-vous cette emplacement publicitaire